MAML: 模型无关的元学习

什么是元学习

元学习是目前人工智能领域一个令人振奋的研究领域。大量的研究结果表明元学习已经在人工智能领域上取得了重大突破。在正式介绍元学习之前,先来看看传统的人工智能模型是如何工作的。

近几年来,深度学习迅速发展,出现了生成式对抗网络(GAN)和胶囊网络(capsule network)等优秀的算法。但深度神经网络存在的一个问题是,我们需要有一个很大的训练集来训练我们的模型,当我们只有很少的数据集时,它很大程度上会失败。再比如说,我们训练了一个深度学习模型来执行任务 A,现在,当我们有一个新的任务 B,并且与 A 密切相关,但是我们不能使用相同的模型。我们需要为任务 B 从头开始训练模型,因此对于每个任务,我们都需要从头开始训练模型,忽略了任务间的相关性。

事实上,人脑中的学习机制具备一种能力。在面对不同的任务时,人脑的学习机制并不相同。即使面对一个新的任务,人们往往也可以很快找到其学习方式。这种可以动态调整学习方式的能力,称为元学习。元学习产生了一个多功能的人工智能模型,它可以学习执行各种任务,而不需要从头开始训练它们。对于一个新的相关任务,它可以利用从以前的任务中获得的学习能力而不必从头开始训练它们。

MAML 算法

深度学习模型通过梯度的反向传播进行学习。然而,基于梯度的优化既不能应对少量的训练样本,也不能在少量的优化步骤内收敛。那么有没有一种方法可以调整优化算法,让模型在少量样本的情况下就能很好的学习?这就是基于优化方法(optimization-based)的元学习算法。

基于优化方法的元学习中,MAML可以说是当中最有名的了,它是一种相当通用的优化算法,可以与基于梯度更新的算法兼容。

其主要思想是:训练模型的初始化参数(initial parameter),使模型能在来自新任务的少量数据上对参数执行数次(1次或多次)的梯度更新后能得到最佳的表现。

MAML 算法的流程

假设所有的任务都来 自于一个任务空间,其分布为 \(p(\mathcal{T})\),我们可以在这个任务空间的所有任务上学习一种通用的表示,这种表示可以经过梯度下降方法在一个特定的单任务上进行精调(fine-tune)。假设一个模型为 \(f(\theta)\),如果我们让这个模型适应到一个新任务 \(\mathcal{T}(m)\)上, 通过一步或多步的梯度下降更新,学习到的任务适配参数为 \[ \theta_{m}^{\prime}=\theta-\alpha \nabla_{\theta} \mathcal{L}_{\mathcal{T}_{m}}\left(f_{\theta}\right) \] 其中 \(\alpha\) 为学习率。这里 \(\theta_{m}^{\prime}\) 可以理解为关于 \(\theta\) 的函数,而不是真正的参数更新。

MAML的目标是学习一个参数 \(\theta\) 使得其经过一个梯度迭代就可以在新任务上达到最好的性能。 \[ \min _{\theta} \sum_{\mathcal{T}_{m} \sim p(\mathcal{T})} \mathcal{L}_{\mathcal{T}_{m}}\left(f\left(\theta_{m}^{\prime}\right)\right)=\sum_{\mathcal{T}_{m} \sim p(\mathcal{T})} \mathcal{L}_{\mathcal{T}_{m}}\left(f\left({\theta}-\alpha \nabla_{\theta} \mathcal{L}_{\mathcal{T}_{m}}\left(f_{\theta}\right)\right)\right) \] 在所有任务上的元优化(Meta-Optimization)也采用梯度下降来进行优化,即

\[ \theta \leftarrow \theta-\beta \nabla_{\theta} \sum_{m=1}^{M} \mathcal{L}_{\mathcal{T}_{m}}\left(f_{\theta_{m}^{\prime}}\right) \] 其中 \(\beta\) 为元学习率,这里为一个真正的参数更新步骤。这里需要计算关于 \(\theta\) 的二阶梯度,但用一级近似通常也可以达到比较好的性能。

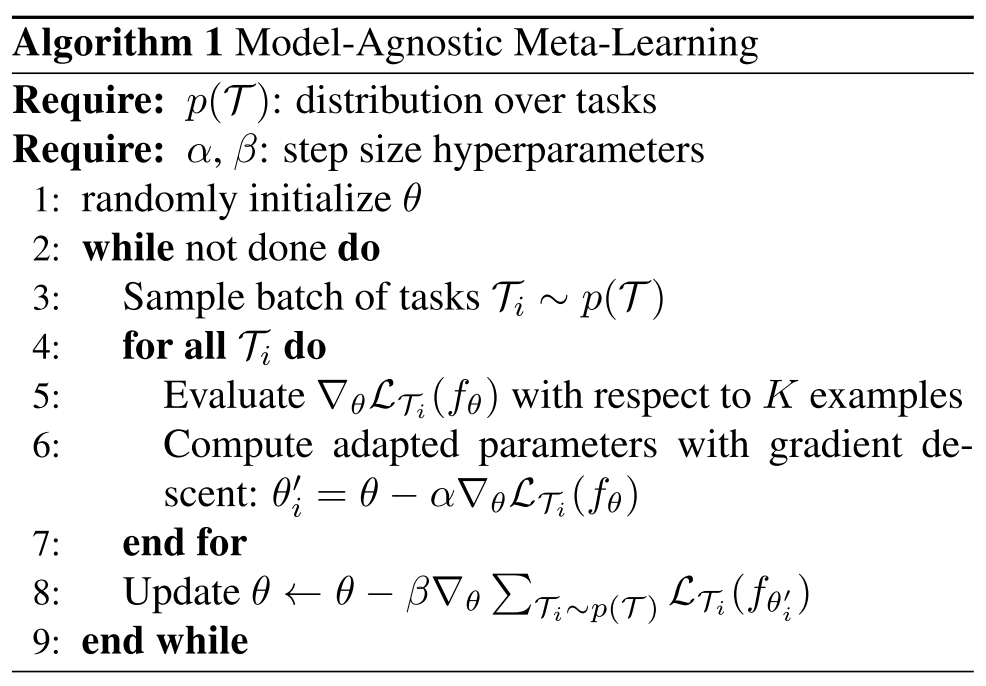

算法描述如下:

算法步骤:

随机初始化参数 \(\theta\)

从任务分布空间 \(p(\mathcal{T})\) 选取若干个任务

在监督学习任务中,任务定义为 \[ \mathscr{T}_{i} \triangleq\left\{p_{i}(\mathbf{x}), p_{i}(\mathbf{y} \mid \mathbf{x}), \mathscr{L}_{i}\right\} \] 其中\[p_{i}(\mathbf{x}), p_{i}(\mathbf{y} \mid \mathbf{x})\]对应了真实的数据生成分布(通常无法得到,但是能够在训练的过程中反映出来),\(\mathscr{L}_{i}\) 表示的是损失函数。不同任务的区别可能是这三个中的某个或者多个不同。

更新任务 \[\mathcal{T}_{i}\] 的参数得到 \[\theta_{i}^{\prime}\]

根据内循环得到的 \(\theta_{i}^{\prime}\) 在其任务\(\mathcal{T}_i\) 上对应的测试集上计算损失(loss),并对初始化参数 \(\theta\) 进行梯度更新

算法过程如下图所示:

\(\theta\) 是初始化参数,也就是元学习的目标,通过不同任务的更新方向去更新 \(\theta\),使得 \(\theta\) 达到一个敏感(sensitive)位置,也就是说任务在这个位置只需要做一步或者几步的梯度下降就会引起损失函数的较大变化,迅速达到该任务的“最优”位置。

MAML 的简单例子

为了理解 MAML 算法是如何寻找一个更好且鲁棒的初始化参数 \(\theta\) 去泛化这些任务的。我们从头实现一个 MAML 算法。

为了方便理解,这里我们考虑一个二分类任务,随机生成一些训练数据,并用一个单层的神经网络去做训练。

生成训练数据

1 | import numpy as np |

测试一下函数

1 | x, y = sample_points(10) |

1 | [0.42100647 0.69403514 0.67855943 0.57774404 0.15666203 0.91099776 |

单层神经网络

为了简单以及方便理解,我们使用只有单层的神经网络来预测输出。如下

1 | a = np.matmul(X, theta) |

所以,我们使用MAML来寻找这个最优的参数值theta,这个参数值是可以在各个任务中通用的。这样对于一个新的任务,我们只进行几次梯度下降,在较少的时间内从几个数据点中学习。

MAML 实现

现在,我们定义一个名为MAML的类,在这个类中我们实现了MAML算法。在 init 方法中,我们将初始化所有必要的变量。然后我们定义我们的 sigmoid 激活函数。接下来我们定义我们的训练函数。

1 | class MAML(object): |

测试

1 | model = MAML() |

输出

1 | Epoch 0: Loss 1.144232040593275 |

MAML 算法的缺点

How to train your MAML 指出了 maml 存在的 5 个问题并给出了改进建议,以下是 maml 存在的 5 个问题

- Training Instabilit

- Second Order Derivative Cost

- Absence of Batch Normalization Statistic Accumulation

- Shared (across step) Batch Normalization Bias

- Shared Inner Loop (across step and across parameter) Learning Rate